El Internet de las Cosas (IoT) y la inteligencia artificial (IA) están transformando la forma en que los dispositivos electrónicos interactúan con el entorno. Comúnmente, estos dispositivos funcionan mediante comandos simples que se envían haciendo clic desde una aplicación móvil conectada a internet, como controlar la iluminación, ajustar la temperatura, abrir o cerrar ventanas, ejecutar comandos en electrodomésticos, etc. Sin embargo, la revolución tecnológica impulsada por la inteligencia artificial está dejando atrás este enfoque. Los nuevos dispositivos ahora utilizan comandos de voz y gestos para ejecutar las tareas, ofreciendo una interacción más intuitiva para el usuario. Además, tienen la capacidad de ejecutar acciones de forma autónoma al recopilar datos del entorno. Para implementar estas capacidades avanzadas en dispositivos de bajo consumo, los desarrolladores recurren a tecnologías como TensorFlow Lite, una herramienta esencial para la incorporación de IA en microcontroladores de manera eficiente.

TensorFlow Lite para Microcontroladores

TensorFlow Lite para microcontroladores es una biblioteca derivada de TensorFlow Lite (LiteRT), optimizada para dispositivos con recursos muy limitados, como microcontroladores, que suelen tener poca memoria y capacidad de procesamiento. LiteRT permite que estos dispositivos puedan ejecutar modelos de IA para realizar tareas como reconocimiento de voz, detección de gestos, monitoreo de datos y más, todo sin la necesidad de conectarse a la nube. Esta autonomía permite que los dispositivos funcionen de forma rápida y segura, ya que procesan la información localmente.

Características clave de TensorFlow Lite para microcontroladores

- Recursos de los modelos: Los modelos utilizados en LiteRT están diseñados para ser compactos, lo que permite su ejecución en dispositivos con tan solo unos pocos kilobytes de memoria RAM y almacenamiento. Este enfoque evita el uso excesivo de recursos y optimiza el rendimiento en dispositivos de baja capacidad.

- Ejecución local: LiteRT está diseñado para ejecutarse en entornos sin sistema operativo (bare-metal) o en sistemas embebidos simples. Esto lo hace ideal para aplicaciones en las que se requiere un rendimiento fiable y constante sin depender de sistemas complejos.

- Compatibilidad: La biblioteca de LiteRT es compatible con microcontroladores basados en ARM Cortex-M, ESP32, entre otros. Esta flexibilidad permite que los desarrolladores puedan aplicar la IA en dispositivos de bajo costo ampliamente disponibles.

- Optimización: Las operaciones de los modelos están optimizadas para sacar el máximo provecho del hardware, garantizando que el consumo de recursos sea mínimo y permitiendo que el dispositivo realice inferencias rápidamente, incluso en microcontroladores con baja capacidad de procesamiento.

- Entrenamiento del modelo: LiteRT está diseñado exclusivamente para la inferencia de modelos. Esto significa que el entrenamiento del modelo debe realizarse en una plataforma más potente, como una computadora de escritorio o en la nube, y luego ser convertido y exportado al microcontrolador para ejecutar las inferencias.

Estas características hacen de LiteRT una opción ideal para el desarrollo de aplicaciones de inteligencia artificial en entornos de hardware limitado, permitiendo la creación de dispositivos más eficientes.

Implementación de los modelos de TensorFlow en un microcontrolador

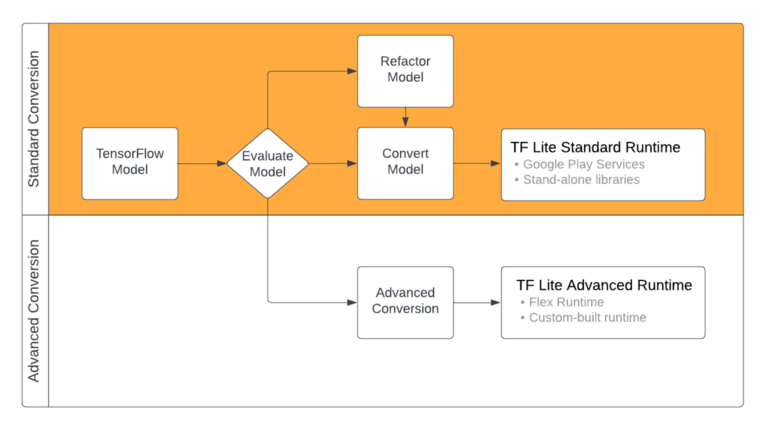

Para implementar inteligencia artificial en un microcontrolador con LiteRT, se siguen varios pasos que adaptan el modelo para ajustarse a las limitaciones del hardware de los microcontroladores. Este flujo de trabajo permite optimizar el modelo para que funcione eficientemente en un entorno con recursos restringidos, como la baja capacidad de memoria y el procesamiento limitado de estos dispositivos.

- Entrenamiento del modelo: El proceso comienza con el desarrollo de un modelo de TensorFlow en una plataforma de cómputo robusta, como una computadora de escritorio. Es crucial que este modelo sea pequeño y que incluya solo las operaciones compatibles con LiteRT, lo que asegura su ejecución en entornos con recursos limitados. En esta fase, el modelo se entrena para cumplir con los requisitos específicos de la aplicación, como reconocimiento de voz, clasificación de imágenes o detección de gestos.

- Conversión a TensorFlow Lite: Una vez que el modelo se ha entrenado y optimizado, se convierte al formato LiteRT. Esta conversión reduce el tamaño del modelo y lo ajusta para su uso en un entorno de microcontrolador, eliminando operaciones innecesarias y optimizando las estructuras de datos para que ocupen menos espacio.

- Conversión a un arreglo de Bytes en C: Después de la conversión a LiteRT, el modelo se transforma en un arreglo de bytes en C. Este paso es necesario para almacenar el modelo en la memoria de solo lectura (ROM) del microcontrolador, lo que permite acceder a él sin consumir espacio en la memoria RAM, una ventaja importante en dispositivos con capacidades limitadas de almacenamiento.

- Ejecución de inferencias en el microcontrolador: Con el modelo almacenado y listo en el dispositivo, se puede realizar inferencia. Para esto, se usa la biblioteca en C++ de LiteRT, que permite que el microcontrolador ejecute el modelo y procese los datos de entrada. Una vez realizada la inferencia, el dispositivo obtiene resultados que puede utilizar para tomar decisiones o desencadenar acciones, como activar un motor, enviar una notificación o clasificar un objeto detectado.

El tamaño y la complejidad del modelo tienen un impacto significativo en la carga de trabajo del microcontrolador. Los modelos grandes y complejos tienden a requerir más procesamiento, lo que significa que el procesador pasa más tiempo activo y menos tiempo en estado de reposo. Esto aumenta el consumo de energía y la generación de calor, lo cual puede representar un problema dependiendo de las limitaciones de energía y los requisitos de funcionamiento continuo de la aplicación. Para mantener la integridad y el rendimiento del dispositivo, es importante optimizar el modelo, equilibrando precisión y eficiencia para minimizar el impacto en el hardware.

Aplicaciones de TensorFlow Lite para microcontroladores

LiteRT permite integrar inteligencia artificial en diversas aplicaciones, posibilitando que los dispositivos interactúen de manera efectiva tanto con el entorno como con el usuario. Gracias a esta tecnología, es posible desarrollar diversas funcionalidades, abriendo un mundo de aplicaciones en áreas como domótica, salud, automatización industrial y dispositivos portátiles.

- Reconocimiento de Voz: Dispositivos como altavoces inteligentes o controles por voz pueden reconocer comandos básicos, como «encender» o «apagar», sin necesidad de conectarse a la nube. Esto ahorra tiempo y ancho de banda, y protege la privacidad.

- Detección de Gestos: Utilizando acelerómetros, se puede detectar y clasificar movimientos o gestos específicos, lo que es útil en dispositivos portátiles o wearables, como pulseras deportivas o relojes inteligentes.

- Monitoreo de datos y detección de anomalías: Sensores de temperatura, humedad o presión pueden monitorear datos en tiempo real y detectar anomalías en equipos industriales o en entornos sensibles. Esto permite identificar problemas rápidamente y prevenir fallos en los sistemas.

- Clasificación de imágenes: Aunque las imágenes de alta resolución no son viables en microcontroladores, es posible realizar clasificaciones sencillas con baja resolución, como identificar objetos básicos en un entorno determinado.

Placas de desarrollo compatibles

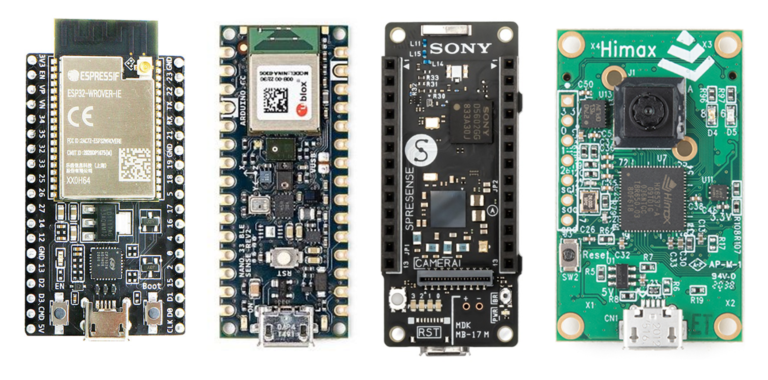

LiteRT se probó en procesadores basados en la arquitectura de la serie ARM Cortex-M y se trasladó a otras arquitecturas, como ESP32 y Arduino.

Es compatible con las siguientes placas de desarrollo:

- Arduino Nano 33 BLE Sense

- SparkFun Edge

- Kit de desarrollo STM32F746

- EdgeBadge de Adafruit

- Kit TensorFlow Lite de Adafruit para microcontroladores

- Circuit Playground Bluefruit de Adafruit

- ESP32-DevKitC de Espressif

- ESP-EYE de Espressif

- Wio Terminal: ATSAMD51

- Placa de desarrollo Himax WE-I Plus EVB Endpoint AI

- Plataforma de desarrollo de software Synopsys DesignWare ARC EM

- Sony Spresense

Ventajas de TensorFlow Lite para microcontroladores

- Eficiencia energética: Procesar datos localmente reduce la necesidad de conexión constante a la nube, lo que disminuye el consumo de energía y hace que LiteRT sea ideal para dispositivos de baja potencia.

- Latencia baja: La inferencia en tiempo real reduce la latencia, ya que el procesamiento se realiza localmente sin depender de una conexión externa. Esto es especialmente importante para dispositivos que necesitan respuestas instantáneas.

- Privacidad y seguridad: Al procesar datos en el propio dispositivo, se minimizan las preocupaciones de privacidad, ya que no es necesario enviar datos sensibles a la nube. Esto resulta crucial para aplicaciones que manejan información personal.

- Costo reducido: Al permitir la IA en dispositivos de bajo costo, LiteRT abre oportunidades para proyectos de bajo presupuesto y aplicaciones comerciales de gran escala.

Desafíos y limitaciones

Si bien LiteRT para microcontroladores abre muchas posibilidades, también presenta algunos desafíos:

- Capacidad limitada de modelos: Los modelos deben ser pequeños y simples para poder ejecutarse en microcontroladores, lo cual puede limitar la precisión o complejidad de las tareas.

- Inferencia únicamente: No es posible entrenar modelos en el microcontrolador; el entrenamiento debe hacerse en hardware más potente y luego portarse al microcontrolador.

- Compatibilidad limitada de operaciones: No todas las operaciones de TensorFlow están disponibles en la versión Lite para microcontroladores, por lo que se requiere un enfoque específico al diseño de los modelos.

LiteRT ha ampliado significativamente las capacidades de los dispositivos de IoT y embebidos, permitiendo la implementación de inteligencia artificial y haciéndolos más eficientes. A medida que avanzamos hacia un mundo cada vez más conectado e inteligente, esta tecnología desempeñará un papel fundamental en el desarrollo de dispositivos capaces de aprender y adaptarse a las formas de interacción con el usuario y el entorno.